Il est déjà difficile de faire des prévisions pour l’année à venir. Et si nous essayions de prédire l’avenir non pas dans un an, mais dans une demi-décennie ?

Plus nous essayons de nous projeter dans l’avenir, plus les choses semblent floues et plus notre réflexion doit devenir spéculative. Si une chose est certaine dans le domaine de la technologie, c’est que personne ne peut prédire l’avenir et que nous serons tous surpris par la façon dont les choses se déroulent.

Mais se lancer dans une expérience de réflexion sur la façon dont les choses vont se dérouler est néanmoins instructif et amusant.

Voici cinq prédictions audacieuses sur ce que sera le monde de l’intelligence artificielle en 2030. Que vous soyez d’accord ou non avec ces prédictions, nous espérons qu’elles vous feront réfléchir.

1. La capitalisation boursière de Nvidia sera significativement inférieure à ce qu’elle est aujourd’hui. Celle d’Intel sera significativement plus élevée qu’elle ne l’est aujourd’hui.

Nvidia est l’entreprise la plus en vue du moment. Elle a été le plus grand bénéficiaire du boom actuel de l’IA générative, avec une capitalisation boursière qui est passée de moins de 300 milliards de dollars à la fin de 2022 à plus de 2 000 milliards de dollars aujourd’hui.

Mais la position de Nvidia en tant que fournisseur dominant de puces pour l’IA ne peut pas durer et ne durera pas.

Ce que Nvidia a construit est difficile, mais pas impossible, à reproduire. AMD, en pleine résurrection, apparaît comme une alternative crédible pour la fourniture de GPU avancés, avec sa nouvelle puce de pointe MI300 sur le point d’être largement disponible. Les grandes entreprises technologiques – Amazon, Microsoft, Alphabet, Meta – investissent toutes massivement dans le développement de leurs propres puces d’IA afin de réduire leur dépendance à l’égard de Nvidia. Sam Altman, de l’OpenAI, cherche à obtenir jusqu’à des milliers de milliards de dollars de capitaux pour créer une nouvelle société de puces afin de diversifier l’offre mondiale de matériel d’IA.

À mesure que la demande de puces d’IA continuera de croître dans les années à venir, les forces implacables du marché garantiront l’arrivée de nouveaux concurrents, l’augmentation de l’offre, la baisse des prix, le resserrement des marges et la diminution de la part de marché de Nvidia.

En outre, à mesure que le marché gagnera en maturité dans les années à venir, le principal type de charge de travail informatique en matière d’IA passera de l’entraînement à l’inférence, c’est-à-dire de la construction de modèles d’IA au déploiement de ces modèles dans le monde réel. Les puces hautement spécialisées de Nvidia sont inégalées lorsqu’il s’agit de former des modèles. Mais l’inférence peut être réalisée avec des puces moins chères et plus banalisées, ce qui pourrait saper l’avantage de Nvidia sur le marché et créer une ouverture pour les concurrents.

Cela ne veut pas dire que Nvidia ne sera pas encore un élément important de l’écosystème de l’IA en 2030. Mais la montée en flèche actuelle du cours de son action – qui en a fait la troisième entreprise la plus précieuse au monde à l’heure où nous écrivons ces lignes, plus importante qu’Amazon ou Alphabet – ressemblera rétrospectivement à de l’exubérance irrationnelle.

En attendant, quelle est la particularité d’Intel par rapport à la quasi-totalité des autres fabricants de puces dans le monde ?

Elle fabrique ses propres puces.

Nvidia, AMD, Qualcomm, Broadcom, Alphabet, Microsoft, Amazon, Tesla, Cerebras, SambaNova, Groq : aucune de ces entreprises ne fabrique ses propres puces. Au contraire, elles conçoivent des puces et s’en remettent à d’autres entreprises – surtout à la Taiwan Semiconductor Manufacturing Company (TSMC) – pour les produire.

Seule Intel possède et exploite ses propres installations de fabrication de puces.

La capacité à fabriquer des puces est devenue un atout géopolitique essentiel. En voici un exemple : La dépendance totale de la Chine à l’égard des fournisseurs étrangers de semi-conducteurs a permis aux États-Unis d’handicaper l’industrie chinoise de l’intelligence artificielle en interdisant l’importation de puces d’intelligence artificielle en Chine.

Les décideurs politiques américains sont parfaitement conscients des vulnérabilités posées par l’extrême concentration de la fabrication de puces à Taïwan aujourd’hui, d’autant plus que la Chine adopte une position de plus en plus dure à l’égard de l’île. La promotion de la fabrication de semi-conducteurs avancés sur le sol américain est devenue une priorité politique majeure pour le gouvernement américain. Les législateurs américains prennent des mesures décisives pour atteindre cet objectif, notamment en engageant la somme colossale de 280 milliards de dollars dans le cadre de la loi CHIPS 2022.

Ce n’est un secret pour personne qu’Intel s’est laissé distancer par TSMC au cours de la dernière décennie dans sa capacité à fabriquer des puces de pointe. Pourtant, elle reste l’une des rares entreprises au monde capables de fabriquer des semi-conducteurs avancés. Sous la direction de Pat Gelsinger, qui a pris les rênes de l’entreprise en 2021, Intel a redéfini ses priorités en matière de fabrication de puces et a mis en place une stratégie ambitieuse pour reconquérir sa place de premier fabricant mondial de puces. Des signes récents indiquent que l’entreprise progresse vers cet objectif.

Et ce qui est peut-être le plus important, c’est qu’il n’y a tout simplement pas d’autre option pour devenir le leader américain de la fabrication de puces.

La secrétaire américaine au commerce, Gina Raimundo, qui dirige les efforts de l’administration Biden en matière d’IA et de puces, l’a reconnu directement dans un récent discours : « Intel est le champion national des puces ».

En d’autres termes, l’Amérique a besoin d’Intel. Et cela est de bon augure pour les perspectives commerciales d’Intel.

La capitalisation boursière de Nvidia s’élève aujourd’hui à 2 200 milliards de dollars. Celle d’Intel, qui s’élève à 186 milliards de dollars, est inférieure de plus d’un ordre de grandeur. Nous prévoyons que cet écart se sera considérablement réduit d’ici 2030.

2. Nous interagirons avec un large éventail d’IA dans notre vie quotidienne aussi naturellement que nous interagissons aujourd’hui avec d’autres humains.

Bien que le monde entier soit actuellement en pleine effervescence autour de l’intelligence artificielle, le nombre de points de contact que l’individu moyen a réellement avec les systèmes d’IA de pointe est aujourd’hui limité : une requête occasionnelle à ChatGPT ou Google Bard/Gemini, peut-être.

D’ici à 2030, la situation aura radicalement changé.

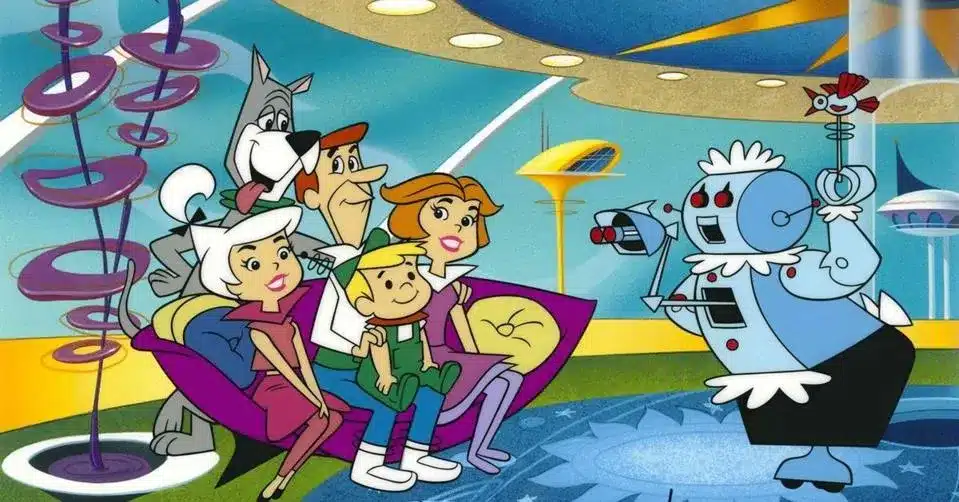

Les IA deviendront nos assistants personnels, nos tuteurs, nos conseillers d’orientation, nos thérapeutes, nos comptables, nos avocats.

Elles seront omniprésentes dans notre vie professionnelle : elles effectueront des analyses, écriront des codes, construiront des produits, vendront des produits, assisteront les clients, coordonneront les équipes et les organisations, prendront des décisions stratégiques.

Et oui, d’ici 2030, il sera courant pour les humains d’avoir des IA comme proches.

Comme pour toute nouvelle technologie, il y aura une courbe d’adoption. Certaines parties de la population s’adapteront plus facilement à l’interaction avec leurs nouveaux pairs IA ; d’autres résisteront plus longtemps. La prolifération des IA dans notre société se déroulera comme la célèbre phrase d’Ernest Hemingway sur la façon dont les gens font faillite : « Graduellement, puis soudainement ».

Les modèles génératifs capables de tenir une conversation éclairée sur n’importe quel sujet, de produire des vidéos de haute qualité à la demande ou d’écrire des codes complexes représentent des avancées importantes dans le domaine de l’intelligence artificielle. Mais toutes ces avancées se produisent dans le monde des logiciels, le monde des bits.

Il existe un tout autre domaine qui attend d’être transformé par l’IA de pointe d’aujourd’hui : le monde physique, le monde des atomes.

Le domaine de la robotique existe depuis des décennies, bien sûr. Il existe aujourd’hui dans le monde des millions de robots qui automatisent différents types d’activités physiques.

Mais les robots d’aujourd’hui ont des capacités étroitement définies et une intelligence limitée. Ils sont généralement conçus pour une tâche particulière – par exemple, déplacer des cartons dans un entrepôt, réaliser une étape spécifique d’un processus de fabrication ou passer l’aspirateur sur un sol. Ils sont loin de posséder la fluidité d’adaptation et la compréhension généralisée des grands modèles de langage comme ChatGPT.

Cette situation va changer dans les années à venir. L’IA générative va conquérir le monde des atomes et fera paraître modeste, en comparaison, tout ce qui s’est passé jusqu’à présent dans le domaine de l’IA.

Depuis l’aube de l’informatique numérique, un thème récurrent dans la technologie a été de rendre les plateformes matérielles aussi générales que possible et de préserver autant de flexibilité que possible pour la couche logicielle.

Ce principe a été défendu par Alan Turing lui-même, le parrain intellectuel des ordinateurs et de l’intelligence artificielle, qui l’a immortalisé dans son concept de « machine de Turing » : une machine capable d’exécuter n’importe quel algorithme possible.

L’évolution précoce de l’ordinateur numérique a validé l’intuition fondamentale de Turing. Dans les années 1940, différents ordinateurs physiques étaient construits pour des tâches différentes : l’un pour calculer la trajectoire des missiles, par exemple, et l’autre pour déchiffrer les messages de l’ennemi. Mais dans les années 1950, les ordinateurs polyvalents et entièrement programmables se sont imposés comme l’architecture informatique dominante. Leur polyvalence et leur adaptabilité aux différents cas d’utilisation se sont avérées un avantage décisif : ils pouvaient être continuellement mis à jour et utilisés pour toute nouvelle application simplement en écrivant un nouveau logiciel.

Plus récemment, grâce au génie de Steve Jobs et d’autres, de nombreux appareils physiques différents ont été regroupés en un seul produit, l’iPhone : téléphone, appareil photo, magnétoscope, magnétophone, lecteur MP3, navigateur GPS, lecteur de livres électroniques, appareil de jeu, lampe de poche, boussole.

(Un schéma analogue peut même être tracé dans la trajectoire récente des modèles d’intelligence artificielle, bien que dans cet exemple tout soit logiciel. Les modèles étroits et spécifiques à une fonction – un modèle pour la traduction linguistique, un autre pour l’analyse des sentiments, etc. – ont cédé la place, au cours des dernières années, à des « modèles de base » polyvalents capables d’exécuter toute la gamme des tâches en aval).

Nous assisterons à la même évolution dans le domaine de la robotique au cours des prochaines années : nous nous éloignerons des machines spécialisées dont les cas d’utilisation sont étroitement définis pour nous tourner vers une plateforme matérielle plus polyvalente, plus flexible, plus adaptable et plus universelle.

À quoi ressemblera cette plateforme matérielle polyvalente ? Quel facteur de forme devra-t-elle avoir pour agir avec souplesse dans un large éventail d’environnements physiques différents ?

La réponse est claire : elle devra ressembler à un être humain.

Toute notre civilisation a été conçue et construite par des humains, pour des humains. Notre infrastructure physique, nos outils, nos produits, la taille de nos bâtiments, la taille de nos chambres, la taille de nos portes : tout est optimisé pour les corps humains. Si nous voulons développer un robot généraliste capable d’opérer dans les usines, les entrepôts, les hôpitaux, les magasins, les écoles, les hôtels et nos maisons, ce robot devra avoir la même forme que nous. Aucun autre facteur de forme ne fonctionnerait aussi bien.

C’est pourquoi les possibilités offertes par les robots humanoïdes sont si vastes. L’introduction de l’IA de pointe dans le monde réel est la prochaine grande frontière de l’intelligence artificielle.

Les grands modèles de langage automatiseront de vastes pans du travail cognitif dans les années à venir. Parallèlement, les robots humanoïdes automatiseront de vastes pans du travail physique.

Et ces robots ne sont plus un lointain rêve de science-fiction. Bien que la plupart des gens ne le réalisent pas encore, les humanoïdes sont sur le point d’être déployés dans le monde réel.

Mais ne vous y trompez pas : cette transition sera inévitable. Elle sera inévitable parce que l’IA sera capable de faire une grande partie de ce que les humains font aujourd’hui, mais à moindre coût, plus rapidement et de manière plus fiable.

3. Plus de cent mille robots humanoïdes seront déployés dans le monde réel.

L’essor actuel de l’IA s’est déroulé presque entièrement dans le domaine numérique.

Les modèles génératifs capables de tenir une conversation éclairée sur n’importe quel sujet, de produire des vidéos de haute qualité à la demande ou d’écrire des codes complexes représentent des avancées importantes dans le domaine de l’intelligence artificielle. Mais toutes ces avancées se produisent dans le monde des logiciels, le monde des bits.

Il existe un tout autre domaine qui attend d’être transformé par l’IA de pointe d’aujourd’hui : le monde physique, le monde des atomes.

Le domaine de la robotique existe depuis des décennies, bien sûr. Il existe aujourd’hui dans le monde des millions de robots qui automatisent différents types d’activités physiques.

Mais les robots d’aujourd’hui ont des capacités étroitement définies et une intelligence limitée. Ils sont généralement conçus pour une tâche particulière – par exemple, déplacer des cartons dans un entrepôt, réaliser une étape spécifique d’un processus de fabrication ou passer l’aspirateur sur un sol. Ils sont loin de posséder la fluidité d’adaptation et la compréhension généralisée des grands modèles de langage comme ChatGPT.

Cette situation va changer dans les années à venir. L’IA générative va conquérir le monde des atomes et fera paraître modeste, en comparaison, tout ce qui s’est passé jusqu’à présent dans le domaine de l’IA.

Depuis l’aube de l’informatique numérique, un thème récurrent dans la technologie a été de rendre les plateformes matérielles aussi générales que possible et de préserver autant de flexibilité que possible pour la couche logicielle.

Ce principe a été défendu par Alan Turing lui-même, le parrain intellectuel des ordinateurs et de l’intelligence artificielle, qui l’a immortalisé dans son concept de « machine de Turing » : une machine capable d’exécuter n’importe quel algorithme possible.

L’évolution précoce de l’ordinateur numérique a validé l’intuition fondamentale de Turing. Dans les années 1940, différents ordinateurs physiques étaient construits pour des tâches différentes : l’un pour calculer la trajectoire des missiles, par exemple, et l’autre pour déchiffrer les messages de l’ennemi. Mais dans les années 1950, les ordinateurs polyvalents et entièrement programmables se sont imposés comme l’architecture informatique dominante. Leur polyvalence et leur adaptabilité aux différents cas d’utilisation se sont avérées un avantage décisif : ils pouvaient être continuellement mis à jour et utilisés pour toute nouvelle application simplement en écrivant un nouveau logiciel.

Plus récemment, grâce au génie de Steve Jobs et d’autres, de nombreux appareils physiques différents ont été regroupés en un seul produit, l’iPhone : téléphone, appareil photo, magnétoscope, magnétophone, lecteur MP3, navigateur GPS, lecteur de livres électroniques, appareil de jeu, lampe de poche, boussole.

(Un schéma analogue peut même être tracé dans la trajectoire récente des modèles d’intelligence artificielle, bien que dans cet exemple tout soit logiciel. Les modèles étroits et spécifiques à une fonction – un modèle pour la traduction linguistique, un autre pour l’analyse des sentiments, etc. – ont cédé la place, au cours des dernières années, à des « modèles de base » polyvalents capables d’exécuter toute la gamme des tâches en aval).

Nous assisterons à la même évolution dans le domaine de la robotique au cours des prochaines années : nous nous éloignerons des machines spécialisées dont les cas d’utilisation sont étroitement définis pour nous tourner vers une plateforme matérielle plus polyvalente, plus flexible, plus adaptable et plus universelle.

À quoi ressemblera cette plateforme matérielle polyvalente ? Quel facteur de forme devra-t-elle avoir pour agir avec souplesse dans un large éventail d’environnements physiques différents ?

La réponse est claire : elle devra ressembler à un être humain.

Toute notre civilisation a été conçue et construite par des humains, pour des humains. Notre infrastructure physique, nos outils, nos produits, la taille de nos bâtiments, la taille de nos chambres, la taille de nos portes : tout est optimisé pour les corps humains. Si nous voulons développer un robot généraliste capable d’opérer dans les usines, les entrepôts, les hôpitaux, les magasins, les écoles, les hôtels et nos maisons, ce robot devra avoir la même forme que nous. Aucun autre facteur de forme ne fonctionnerait aussi bien.

C’est pourquoi les possibilités offertes par les robots humanoïdes sont si vastes. L’introduction de l’IA de pointe dans le monde réel est la prochaine grande frontière de l’intelligence artificielle.

Les grands modèles de langage automatiseront de vastes pans du travail cognitif dans les années à venir. Parallèlement, les robots humanoïdes automatiseront de vastes pans du travail physique.

Et ces robots ne sont plus un lointain rêve de science-fiction. Bien que la plupart des gens ne le réalisent pas encore, les humanoïdes sont sur le point d’être déployés dans le monde réel.

Tesla investit massivement dans le développement d’un robot humanoïde, baptisé Optimus. L’entreprise prévoit de commencer à livrer les robots aux clients en 2025.

Elon Musk, PDG de Tesla, a déclaré sans ambages l’importance qu’il accorde à cette technologie pour l’entreprise et le monde entier : « Je suis surpris que les gens ne réalisent pas l’ampleur du programme du robot Optimus. L’importance d’Optimus deviendra évidente dans les années à venir. Ceux qui sont perspicaces ou qui regardent, écoutent attentivement, comprendront qu’Optimus vaudra finalement plus que l’activité automobile de Tesla, plus que [la conduite autonome complète]. »

Une poignée de jeunes entreprises font également des progrès rapides dans ce domaine.

La semaine dernière, Figure, basée dans la Bay Area, a annoncé une levée de fonds de 675 millions de dollars auprès d’investisseurs tels que Nvidia, Microsoft, OpenAI et Jeff Bezos. Il y a quelques mois, l’entreprise a publié une vidéo impressionnante de son robot humanoïde en train de préparer une tasse de café.

Une autre start-up humanoïde de premier plan, 1X Technologies, a annoncé un financement de 100 millions de dollars en janvier. 1X propose déjà à la vente une version de son robot humanoïde (avec des roues) et prévoit de lancer bientôt la prochaine génération (avec deux jambes).

Au cours des prochaines années, ces entreprises passeront des projets pilotes à petite échelle à la production de masse. D’ici la fin de la décennie, il faut s’attendre à voir des centaines de milliers (voire des millions) de robots humanoïdes déployés dans le monde réel.

4. Les termes « agents » et « AGI » seront dépassés et ne seront plus couramment utilisés.

Les agents et l’intelligence générale artificielle (AGI) sont deux des sujets les plus brûlants de l’IA aujourd’hui.

Les agents sont des systèmes d’intelligence artificielle capables d’accomplir des tâches vaguement définies : par exemple, planifier et réserver votre prochain voyage. L’AGI fait référence à un système d’intelligence artificielle qui atteint ou dépasse les capacités humaines dans toutes les dimensions.

Lorsque les gens envisagent l’état de l’IA en 2030, les agents et/ou l’AGI sont souvent au premier plan.

Pourtant, nous prévoyons que ces deux termes ne seront même pas largement utilisés d’ici 2030. Pourquoi ? Parce qu’ils ne seront plus pertinents en tant que concepts indépendants.

Commençons par les « agents ».

D’ici 2030, le comportement des agents sera devenu un élément fondamental et essentiel de tout système d’IA avancé.

Ce que nous appelons aujourd’hui « agents » n’est en fait qu’un ensemble de capacités essentielles que possède toute entité véritablement intelligente : la capacité de penser à long terme, de planifier et de prendre des mesures en vue d’atteindre des objectifs à durée indéterminée. Devenir « agentique » est l’aboutissement naturel et inévitable de l’intelligence artificielle d’aujourd’hui. En 2030, les systèmes d’IA de pointe ne se contenteront pas de produire des résultats lorsqu’on le leur demandera ; ils feront en sorte que les choses se fassent.

En d’autres termes, les « agents » ne seront plus un sous-domaine intrigant de la recherche sur l’IA, comme c’est le cas aujourd’hui. L’IA sera constituée d’agents, et les agents seront l’IA. Le terme « agent » en tant que concept autonome n’aura donc plus de raison d’être.

Qu’en est-il du terme « AGI » ?

L’intelligence artificielle est fondamentalement différente de l’intelligence humaine, une vérité de base que les gens ne parviennent souvent pas à saisir.

L’IA va devenir incroyablement plus puissante dans les années à venir. Mais nous cesserons de conceptualiser sa trajectoire comme se dirigeant vers un état final « généralisé », en particulier un état dont les contours sont définis par les capacités humaines.

Yann LeCun, grand spécialiste de l’IA, l’a bien résumé : « L’AGI n’existe pas….Même les humains sont spécialisés ».

L’utilisation de l’intelligence humaine comme point d’ancrage et critère ultime pour le développement de l’intelligence artificielle ne permet pas de reconnaître l’ensemble des capacités puissantes, profondes, inattendues, bénéfiques pour la société et totalement non humaines dont l’intelligence des machines pourrait être capable.

D’ici 2030, l’IA sera incroyablement plus puissante que l’homme et transformera notre monde. Elle restera également à la traîne des capacités humaines à d’autres égards. Si une intelligence artificielle peut, par exemple, comprendre et expliquer chaque détail de la biologie humaine jusqu’au niveau atomique, qu’importe qu’elle soit « générale », c’est-à-dire qu’elle puisse égaler les capacités humaines dans tous les domaines ?

Le concept d’intelligence artificielle générale n’est pas particulièrement cohérent. Au fur et à mesure que l’IA progresse dans les années à venir, le terme deviendra de moins en moins utile et de moins en moins pertinent.

5. La perte d’emploi due à l’IA sera l’une des questions politiques et sociales les plus débattues.

Les inquiétudes concernant la perte d’emploi due à la technologie sont un thème familier de la société moderne, qui remonte à la révolution industrielle et aux luddites. L’ère de l’IA ne fait pas exception.

Mais jusqu’à présent, les discussions concernant l’impact de l’IA sur les marchés de l’emploi ont été essentiellement théoriques et axées sur le long terme, confinées à la recherche universitaire et aux livres blancs des groupes de réflexion.

Cette situation va changer beaucoup plus brusquement que la plupart des gens ne le pensent. Avant la fin de la décennie, la perte d’emploi due à l’IA sera une réalité concrète et urgente dans la vie quotidienne des citoyens.

Nous commençons déjà à voir des canaris dans la mine de charbon. Le mois dernier, le géant de la fintech Klarna a annoncé que son nouveau système d’IA pour le service à la clientèle prenait en charge le travail de 700 agents humains à temps plein. La société Turnitin, spécialisée dans la détection du plagiat, a récemment annoncé qu’elle réduirait ses effectifs de 20 % au cours des 18 prochains mois grâce aux progrès de l’IA.

Dans les années à venir, les organisations découvriront qu’elles peuvent accroître leur rentabilité et leur productivité en utilisant l’IA pour effectuer de plus en plus de tâches qui nécessitaient auparavant l’intervention de l’homme. Cela se produira dans tous les secteurs et à tous les niveaux de rémunération : des agents du service clientèle aux comptables, des scientifiques des données aux caissiers, des avocats aux agents de sécurité, des sténographes judiciaires aux pathologistes, des chauffeurs de taxi aux consultants en gestion, des journalistes aux musiciens.

Il ne s’agit pas d’une possibilité lointaine. Dans de nombreux cas, la technologie est déjà suffisamment performante aujourd’hui.

Si nous sommes honnêtes avec nous-mêmes, l’une des principales raisons pour lesquelles nous sommes tous si enthousiastes à propos de l’IA – l’une des principales raisons pour lesquelles l’IA offre de telles possibilités de transformation économique – est qu’elle sera capable de faire les choses à moindre coût, plus rapidement et avec plus de précision que les humains ne peuvent le faire aujourd’hui. Une fois que l’IA pourra tenir cette promesse, il sera moins nécessaire et moins justifié économiquement d’employer autant d’humains qu’aujourd’hui dans la plupart des domaines. Presque par définition, pour que l’IA ait un impact sur la société et l’économie, elle prendra des emplois. Bien entendu, de nouveaux emplois seront également créés, mais moins rapidement et en moins grand nombre, du moins dans un premier temps.

Cette perte d’emplois s’accompagnera d’une douleur et d’une dislocation considérables à court terme. Des mouvements et des dirigeants politiques s’opposeront farouchement à cette tendance. D’autres segments de la société défendront tout aussi vocalement les avantages de la technologie et de l’IA. Les troubles civils et les protestations seront inévitables ; ils deviendront sans doute parfois violents.

Les citoyens réclameront à cor et à cri que leurs élus agissent, dans un sens ou dans un autre. Des propositions politiques créatives, comme le revenu de base universel, passeront du stade de théories marginales à celui de lois adoptées.

Il n’y aura pas de solutions faciles ni de choix éthiques tranchés. Les affiliations politiques et les identités sociales seront de plus en plus déterminées par les opinions de chacun sur la manière dont la société devrait gérer la diffusion de l’IA dans l’économie.

Si vous pensez que le moment politique de 2024 est tumultueux, attachez votre ceinture.