Bientôt, notre quotidien sera peuplé d’agents conversationnels d’intelligence artificielle (IA) conçus pour nous assister à chaque instant, anticipant nos désirs et nos besoins afin de nous fournir des informations personnalisées et d’effectuer des tâches utiles à notre place. Pour ce faire, ils exploiteront une vaste réserve de données personnelles sur nos centres d’intérêt et nos loisirs individuels, nos origines et nos aspirations, nos traits de personnalité et nos opinions politiques – le tout dans le but de rendre notre vie « plus pratique ».

Ces agents seront extrêmement compétents. Cette semaine encore, OpenAI a dévoilé GPT-4, son chatbot de nouvelle génération capable de lire les émotions humaines. Il peut y parvenir non seulement en analysant le sentiment dans le texte que vous écrivez, mais aussi en évaluant les inflexions de votre voix (si vous lui parlez par micro) et en utilisant vos expressions faciales (si vous interagissez par vidéo).

C’est l’avenir de l’informatique, et il arrive à grands pas. Google a annoncé Project Astra, abréviation de « Advanced Seeing and Talking Responsive Agent » (agent réactif avancé capable de voir et de parler). L’objectif est de déployer une IA d’assistance capable d’interagir de manière conversationnelle avec vous tout en comprenant ce qu’elle voit et entend dans votre environnement. Cela lui permettra de vous fournir des conseils et une assistance interactifs en temps réel.

Sam Altman, d’OpenAI, a déclaré au MIT Technology Review que l’application reine de l’IA serait les agents d’assistance.En fait, il a prédit que tout le monde voudra un agent d’IA personnalisé qui agit comme « un collègue hypercompétent qui sait absolument tout sur votre vie entière, chaque email, chaque conversation que vous avez eue », le tout capturé et analysé pour pouvoir entreprendre des actions utiles en votre nom.

Qu’est-ce qui pourrait mal se passer ?

Il existe un risque important que les agents d’IA soient utilisés à mauvais escient, d’une manière qui compromette l’autonomie humaine. En fait, je pense que la manipulation ciblée est la menace la plus dangereuse posée par l’IA dans un avenir proche, surtout lorsque ces agents seront intégrés aux appareils mobiles. Après tout, les appareils mobiles sont la porte d’entrée vers notre vie numérique, des informations et des opinions que nous consommons à chaque email, appel téléphonique et SMS que nous recevons. Ces agents surveilleront notre flux d’informations, apprendront des détails intimes sur notre vie, tout en filtrant le contenu qui parvient à nos yeux.

Tout système qui surveille notre vie et filtre les informations que nous recevons est un vecteur de manipulation interactive.Pour rendre la situation encore plus dangereuse, ces agents d’IA utiliseront les caméras et les microphones de nos appareils mobiles pour voir ce que nous voyons et entendre ce que nous entendons en temps réel. Cette capacité (rendue possible par les modèles de langage multimodal à grande échelle) rendra ces agents extrêmement utiles – capables de réagir aux images et aux sons de votre environnement sans que vous ayez besoin de leur demander conseil. Cette capacité pourrait également être utilisée pour déclencher une influence ciblée qui correspond précisément à l’activité ou à la situation dans laquelle vous êtes engagé.

Pour de nombreuses personnes, ce niveau de suivi et d’intervention semble effrayant. Pourtant, je prédis qu’elles adopteront cette technologie. Après tout, ces agents seront conçus pour améliorer notre vie, nous glissant des conseils à l’oreille tout au long de nos routines quotidiennes, s’assurant que nous n’oublions pas de récupérer notre linge en descendant la rue, nous encadrant pendant que nous apprenons de nouvelles compétences, et même nous coachant dans des situations sociales pour nous faire paraître plus intelligents, plus drôles ou plus confiants.

Cela deviendra une course aux armements entre les entreprises technologiques pour augmenter nos capacités mentales de la manière la plus puissante possible. Et ceux qui choisiront de ne pas utiliser ces fonctionnalités se sentiront rapidement désavantagés. Finalement, cela ne ressemblera même plus à un choix. C’est pourquoi je prédis régulièrement que l’adoption sera extrêmement rapide et deviendra omniprésente d’ici 2030.

Pourquoi ne pas adopter une mentalité augmentée ?

Les agents d’assistance nous donneront des superpouvoirs mentaux, mais nous ne pouvons pas oublier qu’il s’agit de produits conçus pour générer des profits. En les utilisant, nous autoriserons les entreprises à nous murmurer des conseils à l’oreille (et bientôt à nous envoyer des images sous les yeux) qui nous guideront, nous coacheront, nous éduqueront, nous avertiront et nous stimuleront tout au long de nos journées. En

d’autres termes, nous autoriserons les agents d’IA à influencer nos pensées et à guider nos comportements. Utilisés à bon escient, ils pourraient constituer une formidable source d’autonomisation, mais en cas d’abus, ils pourraient facilement devenir l’outil de persuasion ultime.

Cela m’amène au « problème de la manipulation par l’IA » : l’influence ciblée exercée par les agents conversationnels est potentiellement bien plus efficace que les contenus traditionnels. Si vous voulez comprendre pourquoi, il suffit de demander à n’importe quel vendeur compétent. Ils savent que la meilleure façon de convaincre quelqu’un d’acheter un produit ou un service (même s’il n’en a pas besoin) n’est pas de lui remettre une brochure, mais d’engager le dialogue. Un bon vendeur commencera par des plaisanteries amicales pour vous « jauger » et baisser vos défenses. Il vous posera ensuite des questions pour faire ressortir vos éventuelles réserves. Enfin, il adaptera son argumentaire pour surmonter vos objections, en utilisant des arguments soigneusement choisis qui jouent le mieux sur vos besoins ou vos insécurités.

La raison pour laquelle la « manipulation par l’IA » est un risque si important est que les agents d’IA seront bientôt capables de nous influencer de manière interactive et qu’ils seront bien plus compétents que n’importe quel vendeur humain.

Cela s’explique non seulement par le fait que ces agents seront formés aux techniques de vente, à la psychologie comportementale, aux biais cognitifs et à d’autres outils de persuasion, mais aussi par le fait qu’ils disposeront de bien plus d’informations sur nous que n’importe quel vendeur. En fait, si l’agent est votre « assistant personnel », il pourrait en savoir plus sur vous que n’importe quel humain n’en a jamais su. (Pour une description des assistants d’IA dans un avenir proche,lisez ma nouvelle de 2021 « Metavers 2030 »).

D’un point de vue technique, le danger de manipulation des agents d’IA peut se résumer en deux mots simples : « contrôle par rétroaction ». En effet, un agent conversationnel peut se voir attribuer un « objectif d’influence » et travailler de manière interactive pour optimiser l’impact de cette influence sur un utilisateur humain. Il peut y parvenir en exprimant un point de vue, en lisant vos réactions telles qu’elles se manifestent dans vos mots, vos inflexions vocales et vos expressions faciales,puis en adaptant ses tactiques d’influence (à la fois ses mots et son approche stratégique) pour surmonter vos objections et vous convaincre de ce qu’on lui a demandé de déployer.

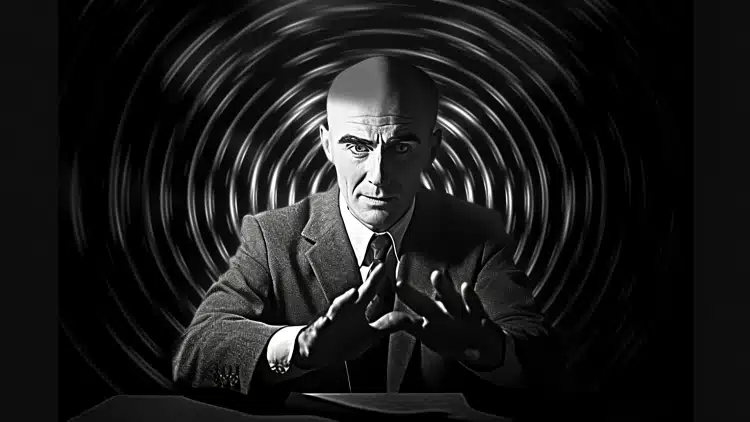

Un système de contrôle de la manipulation humaine est illustré ci-dessus. D’un point de vue conceptuel, il n’est pas très différent des systèmes de contrôle utilisés dans les missiles à tête chercheuse. Ces derniers détectent la signature thermique d’un avion et corrigent leur trajectoire en temps réel s’ils ne sont pas dirigés dans la bonne direction, se dirigeant vers leur cible jusqu’à l’atteindre. À moins d’être réglementés, les agents conversationnels pourront faire la même chose, mais le missile est un élément d’influence, et la cible, c’est vous. Et si l’influence est de la désinformation, de la propagande ou de la mésinformation, le danger est extrême. C’est pourquoi les organismes de réglementation doivent limiter fortement l’influence interactive ciblée.

Ces technologies arrivent-elles bientôt ?

Je suis convaincu que les agents conversationnels auront un impact sur toutes nos vies dans les deux ou trois prochaines années. Après tout, Meta, Google et Apple ont tous fait des annonces qui vont dans ce sens. Par exemple, Meta a récemment lancé une nouvelle version de ses lunettes Ray-Ban dotées d’une intelligence artificielle capable de traiter la vidéo des caméras embarquées, vous donnant des informations sur les éléments que l’IA peut voir dans votre environnement. Apple va également dans cette direction, en annonçant un LLM multimodal qui pourrait donner des yeux et des oreilles à Siri.

Comme je l’ai écrit ici dans VentureBeat, je pense que les caméras seront bientôt incluses dans la plupart des écouteurs haut de gamme pour permettre aux agents d’IA de voir en permanence ce que nous regardons. Dès que ces produits seront disponibles pour les consommateurs, l’adoption se fera rapidement. Ils seront utiles.

Que vous l’attendiez avec impatience ou non, il est clair que les géants de la technologie se précipitent pour placer des agents artificiels dans vos oreilles (et bientôt dans vos yeux) afin qu’ils nous guident partout où nous irons. Ces technologies présentent des avantages indéniables qui amélioreront notre vie quotidienne. En même temps, ces superpouvoirs pourraient facilement être exploités comme des outils de manipulation.

Comment y remédier ?

Je suis fermement convaincu que les organismes de réglementation doivent prendre des mesures rapides dans ce domaine,en veillant à ce que les utilisations positives ne soient pas entravées tout en protégeant le public des abus. La première étape importante serait d’interdire (ou de limiter très strictement) la publicité conversationnelle interactive. C’est essentiellement la « drogue d’entrée » vers la propagande conversationnelle et la désinformation. Le moment est venu pour les décideurs politiques de s’attaquer à ce problème.