L’Augmented World Expo (AWE) a déménagé à Long Beach, en Californie, en 2024, après être devenu trop grand pour le Santa Clara Convention Center, son lieu d’accueil depuis 2010. L’empreinte croissante des expériences numériques dans notre vie quotidienne attire de plus en plus l’attention sur le potentiel de la réalité augmentée et virtuelle (AR/VR).

Sans surprise, l’IA générative était au cœur de l’exposition de cette année (AWE), les développeurs de mondes virtuels et les vendeurs de matériel étant impatients d’accélérer le développement de fonctionnalités cruciales et d’applications phares.

Les appareils de réalité augmentée ont longtemps promis de réduire la friction lors de la fourniture d’informations sur le monde qui nous entoure : Qui est cette personne en face de moi ? Quels sont les principaux points de repère près de moi ?Comment modifier cet espace ?

Ce qui distingue les casques AR/VR montés sur la tête des téléphones et des ordinateurs portables en tant que plateformes d’IA, c’est qu’ils « voient ce que je vois ». Les capteurs et les caméras orientés vers l’avant peuvent fournir à une IA le contexte dont elle a besoin pour répondre directement aux questions liées à la situation actuelle de l’utilisateur.

Au lieu de devoir lever son téléphone pour prendre une photo ou taper une longue description textuelle, un utilisateur pourrait simplement dire « qu’est-ce que je regarde ? » et être récompensé par des données utiles.

Meta Platforms Inc. le fait déjà dans une certaine mesure avec ses lunettes connectées Ray-Ban uniquement audio, qui fournissent un résultat d’IA générative à l’utilisateur via une voix synthétisée.

L’étape suivante consisterait à fournir ces données à l’utilisateur visuellement. Imaginez voir des données dans un tableau de bord ou cartographiées sur une chronologie, le tout sans perdre de vue le monde qui vous entoure.

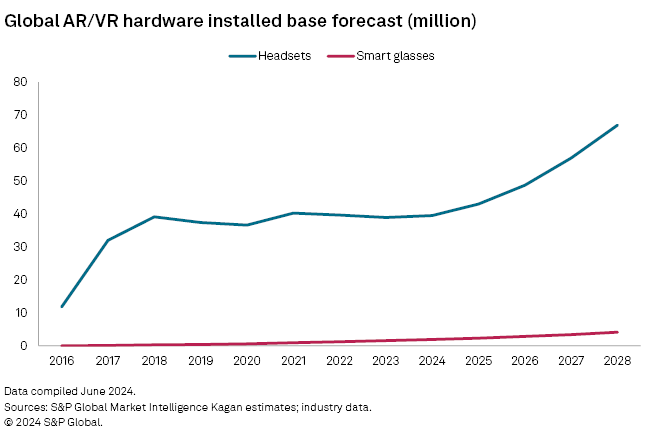

Bien que nous pensons que les lunettes connectées soient l’objectif de la plupart des fabricants de matériel AR/VR, nous ne pensons pas que de tels appareils atteindront le grand public au cours des cinq prochaines années. En revanche, les casques devraient rester le principal facteur de forme, en raison notamment d’un rapport coût-efficacité, d’un affichage et d’options de saisie plus performants.

Pour souligner la convergence future des dispositifs portables avancés et de l’IA, QUALCOMM Inc. a annoncé sur le salon que Ziad Asghar allait occuper un poste de vice-président senior au sein de la division XR de l’entreprise, en apportant son expertise en matière d’IA de son ancien poste de vice-président senior de la gestion des produits.

Asghar et Said Bakadir, responsable de l’activité XR de Qualcomm, se sont entretenus avec un petit groupe d’analystes sur le salon pour expliquer comment le groupe pourrait combler le fossé entre l’IA générative et la réalité augmentée.

Pour illustrer ce propos, l’entreprise a présenté le premier produit équipé de son chipset Snapdragon AR2 Gen 1 dans les lunettes XR de NTT QONOQ Inc.

La démo de QONOQ sur le salon a permis aux utilisateurs de pousser et de tirer des modèles 3D superposés à des montures de lunettes transparentes. Il s’agissait de l’une des meilleures démonstrations de lunettes connectées AR que nous ayons vues jusqu’à présent en termes de précision du suivi des mains et de qualité d’image, même si le champ de vision était limité.

La principale application d’IA de QONOQ est l’interprétation et la traduction en temps réel des conversations se déroulant à portée de voix du casque, mais sa caméra frontale pourrait ouvrir la voie à des applications d’IA générative plus élaborées à l’avenir.

Le principal inconvénient est que les lunettes XR QONOQ nécessitent une connexion sans fil à un smartphone, obligeant les utilisateurs à sacrifier l’autonomie de la batterie au profit de la RA. L’autre inconvénient est qu’elles sont encore un peu encombrantes pour être confondues avec des lunettes ordinaires.

L’appareil est positionné par l’opérateur télécom japonais NTT Docomo Inc. pour stimuler les ventes de téléphones haut de gamme et devrait être disponible pour les consommateurs et les clients commerciaux plus tard cette année.

Shenzhen Yicang Technology Co. Ltd., qui fait des affaires sous le nom de XREAL, pense avoir trouvé un moyen judicieux de combler le fossé entre les lunettes connectées filaires du présent et sa vision d’unités autonomes du futur : en regroupant des lunettes connect

ées avec une tablette Android de la taille d’un smartphone.

XREAL a levé 60 millions de dollars en janvier dernier après une bonne performance de ses lunettes connectées Air 2 Ultra AR au CES.

Son appareil Beam Pro se vend 200 dollars et sera expédié plus tard cette année. Pour ce prix, les utilisateurs de XREAL bénéficient d’une interface similaire à Vision Pro sur des lunettes connectées et de la possibilité de voir deux applications en même temps.

Le Beam Pro est certifié GSM, ce qui signifie qu’il est compatible avec la bibliothèque d’applications Google Play. Il dispose de deux objectifs frontaux qui peuvent être utilisés pour prendre des photos en 3D dans un format pouvant être visualisé avec des lunettes connectées XREAL ainsi que d’autres appareils AR/VR tels que le Quest 3 et Vision Pro.

Les lunettes connectées XREAL sont encore plus un simple écran d’affichage personnel qu’une plateforme AR robuste,mais leurs nouvelles unités Air 2 Ultra combinées au Beam Pro commencent à se rapprocher des fonctionnalités AR de base, telles que l’ancrage d’images dans l’espace. Et, une fois de plus, les caméras frontales offrent la possibilité d’intégrer les applications basées sur l’IA « voir ce que je vois » dont nous avons parlé plus haut.

Qualcomm fournit également le chipset principal pour le Beam Pro avec le nouveau chipset Spatial Companion Processing.

Qualcomm est devenu discrètement le centre de l’univers AR/VR ces dernières années, en itérant régulièrement ses produits phares et en travaillant en étroite collaboration avec des fournisseurs clés pour débloquer de nouveaux cas d’utilisation.

Asghar a tenu à souligner que les applications construites sur la plateforme de développement Snapdragon Spaces seraient compatibles avec la future plateforme AR/VR d’Alphabet Inc.

Cette assurance est venue avec un soupir de soulagement de la part de Qualcomm, qui, après avoir tenté pendant près d’une décennie de répondre aux besoins matériels et logiciels d’une industrie en évolution rapide, pourrait bientôt voir Alphabet prendre une partie du fardeau, au moins en termes de support aux développeurs.

La guerre des guides d’ondes continue

XREAL est le dernier grand partisan de la technologie d’affichage à « bain d’oiseaux », qui nécessite un écran relativement volumineux près des yeux, mais la plupart des entreprises qui construisent des lunettes connectées, y compris NTT, se sont concentrées sur les écrans à guide d’ondes, qui peuvent être intégrés dans les verres et les branches des lunettes connectées.

Le défi est le coût. Produire une image robuste avec un guide d’ondes est une proposition onéreuse. De nombreuses lunettes connectées à guide d’ondes qui sont arrivées sur le marché ont un champ de vision relativement petit, produisent des images délavées et sont souvent d’un coût prohibitif, même pour un usage professionnel.

La dernière vague de lunettes à guide d’ondes, y compris le RayNeo soutenu par TCL et les lunettes XR QONOQ, a fait de grands progrès pour remédier à ces lacunes, mais il reste encore beaucoup de chemin à parcourir.

Le concepteur de composants optiques à guide d’ondes Lumus Ltd. a travaillé sur le problème dans le domaine de la défense et est maintenant prêt à apporter son expérience et son expertise au marché grand public.

La principale différence de Lumus réside dans son approche de guide d’ondes réfléchissant, alors que le reste de l’industrie s’est rallié à une technologie réfractive. Le guide d’ondes réfractive décompose et recompose une image, ce qui peut conduire à une inexactitude des couleurs et à une image faible, alors que le guide d’ondes réfléchissant conserve l’image originale tout au long de la chaîne d’affichage, produisant une image plus précise.

On a longtemps pensé que le réfléchissant était trop cher pour les produits grand public, mais Lumus pense avoir percé ce code en tandem avec Addoptics BV, un fournisseur de solutions de verres correcteurs. Les représentants de la société s’attendent à ce qu’une grande entreprise de technologie produise des lunettes connectées avec son ensemble d’affichage au cours des 18 à 24 prochains mois.

Magic Leap Inc. est une autre entreprise optimiste quant à la production de composants à guide d’ondes pour une plus grande entreprise. Les représentants de la société vantaient les vertus de leur polymère de guide d’ondes en plastique sur le salon, soulignant qu’il pouvait être utilisé dans une large gamme d’appareils.

En d’autres termes, il semble plus probable que jamais que le potentiel à long terme de Magic Leap réside dans la conception et/ou la

fonderie de guides d’ondes et non pas dans la vente de casques autonomes ou de lunettes connectées.

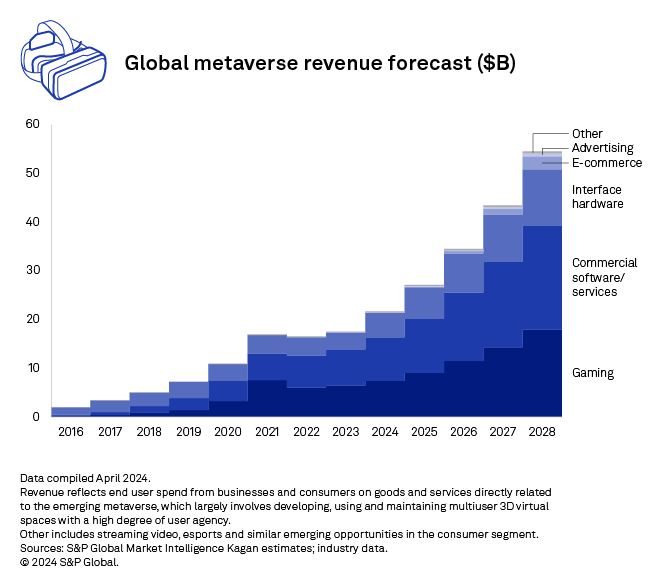

À lire : Les investissements dans le métavers réalisés au premier trimestre de 2024 ont été multipliés par près de cinq par rapport à l’année précédente, atteignant 2,51 milliards de dollars, grâce à des placements importants dans Epic Games et Magic Leap.

La participation de Magic Leap à l’AWE fait suite à l’annonce en mai d’un partenariat avec Alphabet « pour collaborer sur des solutions et des expériences AR ».

Il y a également eu beaucoup de discussions sur et en dehors du salon concernant les ambitions de Meta de produire des lunettes connectées le plus tôt possible, peut-être même dès cette année.

Tout le monde sur le marché

Une autre tendance que nous avons observée sur le salon est le nombre d’entreprises qui étaient restées bloquées dans des cycles de développement apparemment interminables et qui ont choisi cette année pour commencer à expédier leurs produits.

HaptX Inc. nous a annoncé qu’après des années de perfectionnement de sa technologie de retour tactile et de production de kits de développement, elle commencerait à fabriquer des unités commerciales de Gloves G1 avant la fin de l’année.

Les Gloves G1 se portent en tandem avec un casque VR. Lorsque l’utilisateur touche quelque chose dans l’environnement virtuel, des modules dans les gants se gonflent et vibrent pour simuler la sensation de l’objet en question. Lors de la démo,les utilisateurs étaient invités à ramasser un oursin et à sentir des balanes sur une ancre, chacun produisant une sensation réaliste.

RP1 a également déclaré qu’elle ouvrirait une source de revenus plus tard cette année en vendant des parcelles dans sa plateforme de métavers. L’entreprise développe un navigateur ouvert pour le métavers, l’assimilant à un navigateur web traditionnel mais pour les espaces 3D. Considérez le produit de RP1 comme l’achat d’une page web, mais dans le métavers.

Autres points à retenir du salon

-

Tout juste après sa collaboration avec Walmart Inc. pour intégrer le commerce réel dans Roblox Corp., Sawhorse Productions, LLC a affrété un yacht pour accueillir une discussion entre des parties prenantes des hubs du métavers Rec Room Inc., VRChat Inc. et Zepeto de NAVER Z Corp. L’événement a rassemblé de nombreux producteurs de contenu et aspirants publicitaires désireux d’exploiter un nouveau créneau médiatique.

-

La gestion des fichiers 3D devient un problème de plus en plus important à résoudre à mesure que les types de fichiers évoluent et que leur taille augmente. VNTANA Inc. promet de convertir automatiquement un modèle de qualité industrielle en un modèle pouvant être téléchargé sur une page de produit destinée aux consommateurs, ce qui réduit la nécessité de reconcevoir et de reconditionner les actifs. L’entreprise a annoncé une intégration avec l’API de publication d’Amazon lors du salon. Echo3D était également présent pour présenter la capacité de sa plateforme à suivre et à gérer les types de fichiers 3D au sein d’une équipe diffuse.

-

La gestion des appareils est également un point sensible pour le métavers émergent. Holo-Light GmbH a démontré sa capacité à diffuser en continu des modèles d’ingénierie complexes sur un large éventail de casques et d’appareils dans le cloud, tandis qu’ABXR Labs Inc., qui fait des affaires sous le nom d’ArborXR, courtisait les clients des entreprises et de l’industrie à la recherche de solutions matérielles et logicielles dans l’espace AR/VR.

-

Certaines entreprises privées ont contesté notre récente description du métavers comme étant « profondément non rentable ». Alors que la plupart des sociétés cotées en bourse luttent pour dégager des marges sur leurs activités liées au métavers, Apple Inc. étant peut-être la grande exception, certaines petites entreprises ont indiqué avoir déjà trouvé un modèle économique rentable dans le métavers.