Si les partisans du métavers parviennent à leurs fins, nous ferons un jour la queue pour obtenir des soins de santé ou un prêt hypothécaire dans un monde virtuel dirigé par des décideurs virtuels.

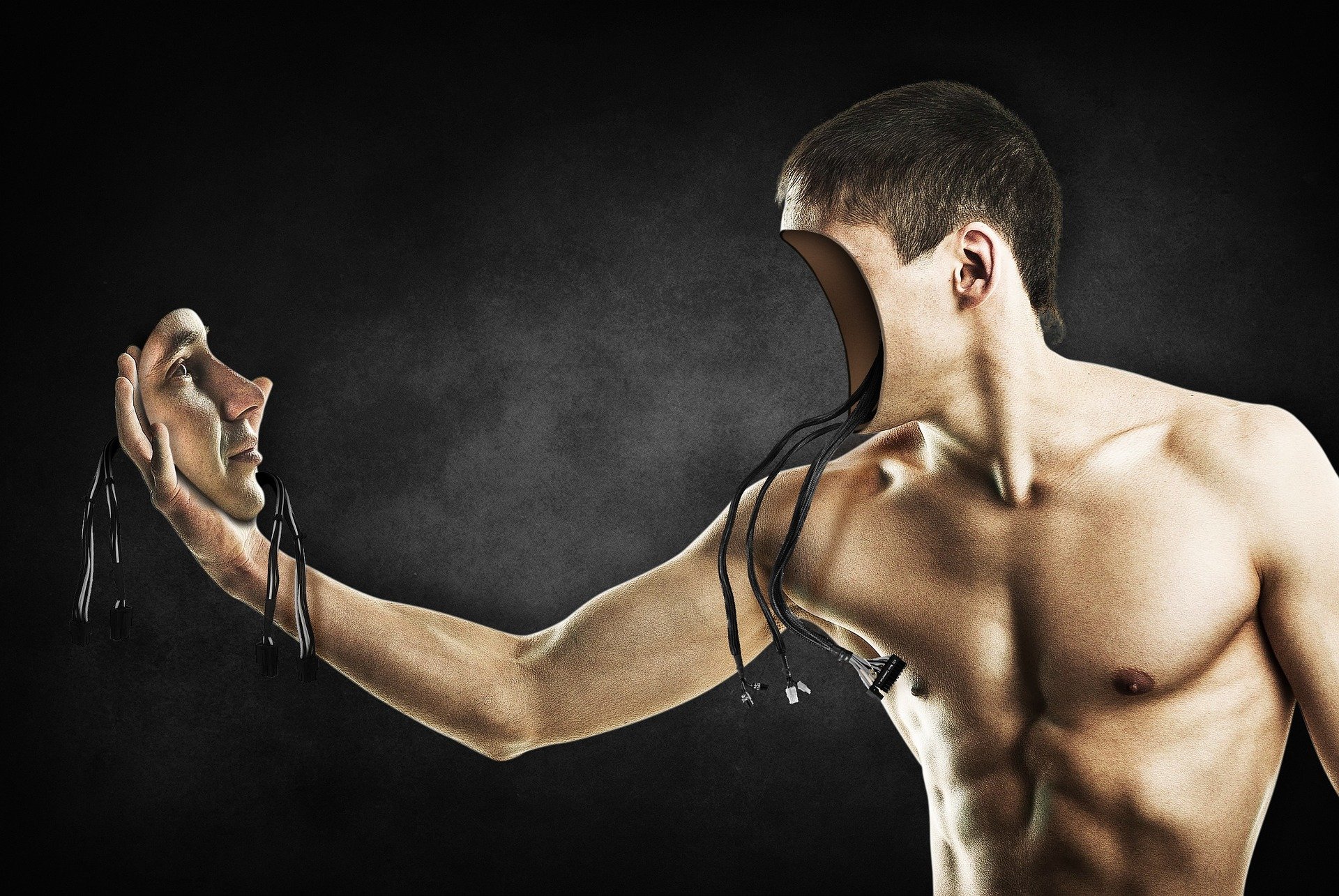

La conception des systèmes d’intelligence artificielle qui pilotent ce monde, qui reste la tâche des humains, présente un réel potentiel de nuisance.

Outre les incitations commerciales, les préjugés implicites qui existent hors ligne et qui sont fondés sur l’origine ethnique, le sexe et l’âge se reflètent souvent dans les grandes données recueillies sur l’internet.

Les modèles d’apprentissage automatique qui sont formés à l’aide de ces ensembles de données intégrant des préjugés adoptent sans surprise ces préjugés.

Par exemple, en 2019, Facebook (aujourd’hui Meta) a été poursuivi par le Département américain du logement et du développement urbain pour avoir « encouragé, permis et provoqué » une discrimination fondée sur la race, le sexe et la religion par le biais de sa plateforme publicitaire.

Facebook a par la suite déclaré qu’il prendrait des « mesures significatives » pour mettre fin à ces comportements, mais il a continué à fournir le même service publicitaire discriminatoire à plus de deux milliards d’utilisateurs sur la base de leurs informations démographiques.

Des défauts techniques lors de la collecte des données, de l’échantillonnage et de la conception du modèle peuvent encore aggraver l’injustice en introduisant des valeurs aberrantes, un biais d’échantillonnage et un biais temporel (lorsqu’un modèle fonctionne bien au début, mais échoue à l’avenir parce que les changements futurs n’ont pas été pris en compte lors de la construction du modèle).

Alors que l’IA envahit de plus en plus notre quotidien quoi qu’il en soit, les gouvernements et les géants de la tech ont commencé à parler d' »IA digne de confiance », un terme formalisé par la Commission européenne en 2019 avec ses lignes directrices en matière d’éthique.

Les lignes directrices parlent de questions d’équité, mais les systèmes actuels sont déjà mis au défi de définir ce qui est équitable sur l’internet actuel, sans parler du métavers.

Une étude récente explorant l’IA digne de confiance et les mesures sélectionnées pour la fournir a révélé que la plupart d’entre elles étaient basées sur une conception axée sur la fonctionnalité, par opposition à une conception centrée sur l’utilisateur.

Si l’on s’intéresse plus particulièrement au classement des moteurs de recherche et aux systèmes de recommandation, nous savons déjà que les classements des moteurs de recherche favorisent parfois systématiquement certains sites par rapport à d’autres, ce qui fausse l’objectivité des résultats et fait perdre la confiance des utilisateurs.

Dans les systèmes de recommandation, le nombre de recommandations est souvent fixé afin de promouvoir des produits ou des publicités présentant de plus grands avantages commerciaux, au lieu de recommandations équitables fondées sur l’utilisation éthique des données.

Pour résoudre ces problèmes et fournir une « IA digne de confiance », les moteurs de recherche doivent garantir que les utilisateurs reçoivent des services neutres et impartiaux.

C’est là que les choses se compliquent.

Une stratégie courante de sélection des mesures consiste à se concentrer sur un facteur et à mesurer l’écart par rapport à l’égalité de ce facteur.

Par exemple, pour les classements dans les moteurs de recherche, il faut se concentrer sur l’attention (potentielle) que les utilisateurs accordent aux articles en fonction de facteurs tels que le taux de clics, l’exposition ou les déductions sur la pertinence du contenu.

Il s’agit ensuite de déterminer l’écart entre ce que voit un utilisateur moyen et ce que voit un utilisateur partial.

Les évaluateurs des systèmes de recommandation ont utilisé des mesures similaires de l’équité, telles que le biais, la moyenne et les disparités de score.

La conception d’une IA fiable et la sélection de métriques dans de tels systèmes se concentrent aussi souvent sur la fonctionnalité pendant des phases spécifiques du cycle de vie.

Idéalement, il faudrait considérer la fiabilité tout au long du cycle de vie de l’utilisation.

Ces considérations seront encore plus importantes dans le métavers.

Immersif par nature, le métavers est davantage lié aux sentiments et aux expériences des utilisateurs que le cyberespace actuel.

Ces expériences sont plus difficiles à quantifier et à évaluer, et posent davantage de problèmes à ceux qui tentent de déterminer ce qu’est une « IA juste ».

L’état d’esprit actuel en matière de conception d’IA digne de confiance et de sélection de métriques, limité par les philosophies de conception susmentionnées, ne prend en considération qu’une partie de la cognition humaine, en particulier les domaines conscients et concrets qui peuvent être plus facilement mesurés et quantifiés.

La reconnaissance des formes, le langage, l’attention, la perception et l’action sont largement explorés par les communautés de l’IA.

L’exploration des domaines inconscients et abstraits de la cognition, tels que la santé mentale et les émotions, est encore récente.

Les limites méthodologiques en sont une raison essentielle, par exemple l’absence de dispositifs et de théories permettant de capter avec précision les signaux bioélectriques et d’en déduire les émotions d’une personne.

Un nouvel ensemble de mesures sera nécessaire dans le métavers pour garantir l’équité.

Les concepteurs devront :

Sélectionner soigneusement les données.

Il est dangereux de se contenter de jeter des données dans un modèle d’IA : les données héritent souvent des préjugés du monde réel où elles ont été recueillies.

Les opérateurs du système doivent sélectionner soigneusement les échantillons de données en veillant à garantir la diversité des données.

Concevoir un système équitable.

Le système doit garantir à tous les utilisateurs une utilisation neutre et ne pas être influencé par des facteurs tels que l’âge, le niveau d’éducation, l’environnement, etc.

Une conception équitable du système peut contribuer à assurer la diversité de la collecte de données.

Concevoir un algorithme d’IA équitable.

Visant à améliorer l’utilité de la majorité, les algorithmes d’IA donnent normalement la priorité à l’optimisation des mesures de performance courantes telles que la précision.

C’est pourquoi de nombreux algorithmes d’IA établissent des seuils pour éviter la participation d’utilisateurs susceptibles d’avoir un impact sur cet objectif, comme ceux qui ont de mauvais réseaux.

Il est important de trouver un équilibre entre les performances de l’algorithme et l’équité pour concevoir des algorithmes d’IA équitables.

Assurer une utilisation équitable.

Après la conception d’un système et d’un algorithme équitables et l’entraînement avec des échantillons de données collectés de manière équitable, l’étape suivante consiste à garantir une utilisation équitable pour tous les utilisateurs, sans préjugés fondés sur l’ethnie, le sexe, l’âge, etc.

Cette dernière partie du cycle est la clé du maintien de l’équité en permettant la collecte continue de données diverses et le retour d’information des utilisateurs pour optimiser l’équité.