L’IA a un impact majeur sur l’industrie du jeu et son influence ne fera que croître dans les années à venir.

L’IA transforme l’industrie du jeu en créant des mondes virtuels plus immersifs, plus attrayants et plus dynamiques. Les projets de jeux utilisent l’intelligence artificielle pour générer des environnements et des personnages plus vrais que nature. Cela permet aux joueurs de s’immerger dans des mondes virtuels qui semblent presque aussi réels que les mondes physiques. L’une des façons les plus significatives dont l’IA modifie les jeux vidéo consiste à améliorer leur réalisme grâce à des innovations en matière de développement de jeux. En outre, les algorithmes d’IA peuvent analyser et interpréter des données provenant de diverses sources – telles que les données du joueur, les facteurs environnementaux et la physique du monde réel – afin de simuler des comportements et des interactions réalistes dans l’univers du jeu.

L’IA et l’animation des mouvements

Avez-vous déjà réfléchi à la manière dont vos personnages se déplacent, courent, sautent ou jouent au ballon dans le jeu ?

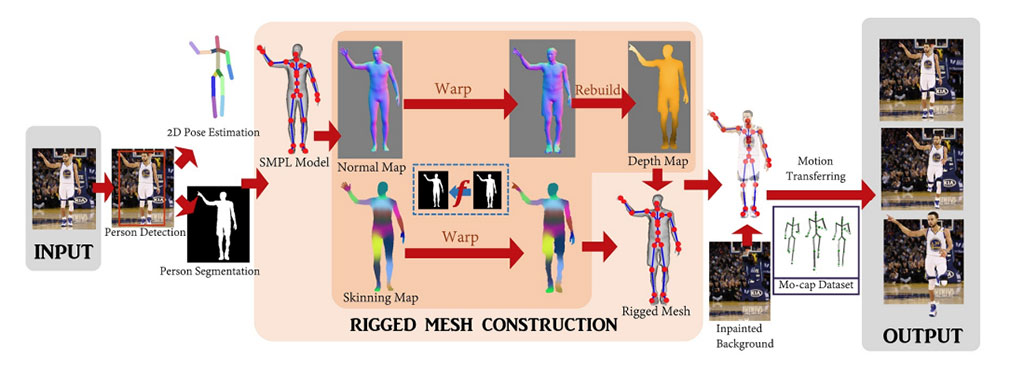

Vous avez peut-être remarqué que les animations des jeux de sport (par exemple FIFA ou NBA) ont souvent l’air réalistes mais répétitives parce qu’elles utilisent un ensemble limité de mouvements fixes provenant d’une base de données. Ces mouvements sont ensuite reproduits par phases et les interactions entre les différents mouvements, par exemple lorsque deux joueurs se heurtent ou dribblent un ballon, sont calculées à l’aide d’une cinématique basée sur la physique. En d’autres termes, les animations sont créées en enregistrant une personne effectuant les mouvements, puis en utilisant ces données pour créer une version numérique des mouvements.

Cependant, le nombre de mouvements enregistrés est limité et la manière dont les mouvements sont combinés peut parfois conduire à des résultats irréalistes et à des dysfonctionnements (voir l’image ci-dessous).

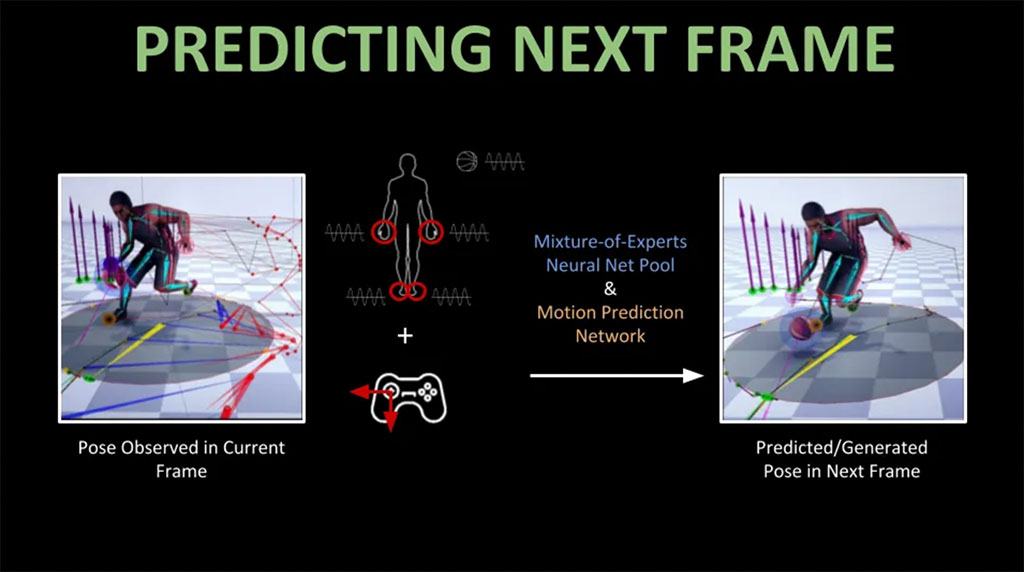

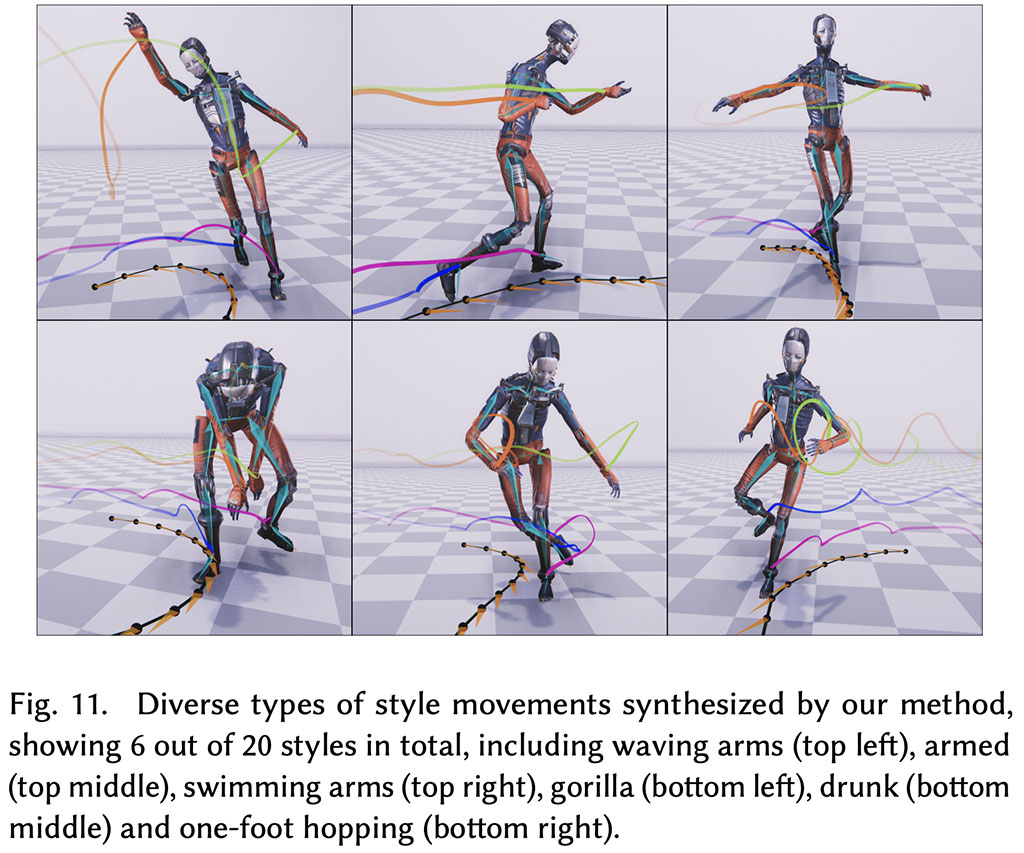

L’animation de mouvement avec l’apprentissage profond peut résoudre ce problème : en utilisant la même base de données de capture de mouvement que celle utilisée pour créer des animations en suivant l’approche décrite ci-dessus, il existe un cadre d’IA qui utilise les phases de mouvement locales pour prédire et générer des mouvements. Ce modèle génératif permet d’éviter les animations visuellement répétitives, rendant ainsi les mouvements plus naturels et dynamiques. En modélisant le mouvement de parties individuelles du corps plutôt que du corps entier, ce cadre rend également les interactions entre les différents joueurs plus réalistes, sans qu’il soit nécessaire de coder à la main la physique qui sous-tend ces interactions.

La synthèse des mouvements des personnages est donc le processus de création de mouvements réalistes et naturels pour les personnages animés. L’un des défis de cette tâche consiste à apprendre la structure spatio-temporelle des mouvements du corps. Il s’agit de comprendre comment les différentes parties du corps se déplacent ensemble au fil du temps.

Dans le travail « DeepPhase : Periodic Autoencoders for Learning Motion Phase Manifolds par Sebastian Starke, Ian Mason, Taku Komura », les auteurs proposent une nouvelle architecture de réseau neuronal appelée Periodic Autoencoder pour apprendre des caractéristiques périodiques à partir de grands ensembles de données de mouvements non structurés de manière non supervisée. Cela signifie que le réseau apprend à identifier et à extraire des motifs répétitifs dans les données de mouvement sans qu’on lui dise explicitement ce qu’il doit rechercher.

Le réseau décompose les mouvements des personnages en plusieurs canaux latents, chacun d’entre eux capturant la périodicité non linéaire d’un segment corporel différent. Par exemple, un canal peut capturer la périodicité d’un mouvement de jambe pendant la marche, tandis qu’un autre canal capture la périodicité du mouvement de bras.

Le réseau extrait ensuite un espace de phase multidimensionnel des données de mouvement du corps entier. Cet espace de phase est une représentation des différentes façons dont les segments du corps peuvent se déplacer ensemble. Il peut être utilisé pour regrouper efficacement les animations et produire un collecteur dans lequel les distances de caractéristiques calculées fournissent de meilleures mesures de similarité que l’espace de mouvement original. Cela signifie que l’espace des phases peut être utilisé pour trouver des animations similaires les unes aux autres en termes de structure spatio-temporelle.

Je suppose que cela semble compliqué. Voici donc une analogie très simple :

Imaginez que vous essayez d’apprendre à danser. L’une des solutions consiste à regarder de nombreuses vidéos de personnes en train de danser et à essayer de copier leurs mouvements. Cependant, cela prendrait beaucoup de temps, serait difficile et vous ne pourriez peut-être pas saisir toutes les nuances des mouvements.

Une autre façon d’apprendre à danser serait d’apprendre les pas de base de la danse et de s’entraîner à les combiner de différentes façons. Il s’agit d’une méthode d’apprentissage plus efficace, mais qui nécessite une bonne compréhension des principes sous-jacents de la danse.

L’autoencodeur périodique est similaire à la deuxième approche. Il apprend les principes de base du mouvement corporel à partir de vastes ensembles de données de mouvement non structurées. Cela lui permet de générer des mouvements réalistes et naturels pour les personnages animés sans qu’on lui dise explicitement comment procéder. Je vous recommande de regarder cette excellente vidéo : EA’s New AI : Next Level Gaming Animation.

Que peut faire d’autre l’IA ? Simuler des mondes virtuels, bien sûr !

Les paysages de l’IA, ça vous dit quelque chose ? J’aimerais souligner que de nombreuses personnes confondent les algorithmes d’apprentissage automatique et les algorithmes génératifs conventionnels. Oui, le premier fait l’objet de beaucoup d’attention, mais le second intéresse également notre équipe pour des applications lors de la création de lieux génératifs en monde ouvert dans notre métavers SIDUS HEROES.

Soyons honnêtes, la plupart des mondes virtuels ne font pas beaucoup d’efforts pour simuler des écosystèmes complexes ; les créateurs ne pensent pas vraiment à la physique et aux écosystèmes basés sur la biologie. Ils ajoutent juste quelques arbres et c’est tout 😉 .

Cependant, si nous voulons que les mondes virtuels soient plus réalistes, des éléments tels que les types de végétation utilisés devraient au moins être déterminés par des facteurs environnementaux tels que les précipitations et la température.

L’IA aide à accélérer les simulations

Tout en construisant le métavers SIDUS HEROES, nous mettons activement en œuvre des outils d’IA qui nous permettent d’accélérer la simulation d’objets dynamiques. Certaines simulations peuvent remplir plusieurs disques durs pour seulement une minute de données de simulation physique – c’est littéralement une quantité folle. Nous avons donc besoin de quelque chose pour nous aider à tout compresser et les scientifiques de NVIDIA nous ont proposé une idée folle !

NVIDIA a développé une nouvelle technique basée sur l’IA, appelée NeuralVDB, qui peut compresser les données de simulation physique jusqu’à 60 fois, tout en conservant la même qualité visuelle. Cette technique pourrait avoir un impact majeur sur un grand nombre d’industries. Elle offre également des améliorations significatives en termes d’efficacité par rapport à OpenVDB, la bibliothèque standard de l’industrie pour la simulation et le rendu de données volumétriques éparses telles que l’eau, le feu, la fumée et les nuages.

L’IA permet d’avoir de vraies conversations avec les PNJ dans les jeux vidéo

Les personnages non joueurs (PNJ) sont une composante majeure de la quasi-totalité des jeux pour mobiles, PC ou consoles. Ils ouvrent l’univers du jeu, l’enrichissent et améliorent la jouabilité de diverses manières. Cependant, les PNJ présentent de nombreux problèmes auxquels les développeurs doivent faire face : par exemple, les personnages secondaires ne sont souvent pas très doués pour avoir des conversations. Ils émettent de simples bruits ou répètent les mêmes phrases à l’infini. Cela s’explique par le fait que les PNJ sont généralement programmés avec un ensemble limité de dialogues préenregistrés.

Selon le rapport sur l’avenir des PNJ réalisé par Inworld AI, la majorité des joueurs pensent que l’amélioration du comportement des PNJ aura un impact positif sur le plaisir de jouer.

L’IA change la donne !Les développeurs utilisent l’IA pour créer des PNJ capables de générer un discours original et audible. Pour ce faire, ils combinent la technologie GPT avec la technologie de synthèse vocale. Certains de ces PNJ peuvent même entraîner les joueurs dans de nouvelles histoires.

Vous pouvez en avoir un aperçu grâce à une démo récemment publiée par Replica Studios, qui présente une version modifiée du jeu Matrix Awakens. Elle vous permet d’utiliser votre propre microphone pour converser avec les PNJ dans les rues de la ville. La démo offre un aperçu maladroit mais fascinant de la manière dont l’IA vocale pourrait bientôt rendre les jeux vidéo beaucoup plus immersifs, en permettant aux studios de jeu d’augmenter l' »interopérabilité » sociale des mondes virtuels d’une manière qui serait pratiquement impossible avec des acteurs vocaux humains.

Dans l’ensemble, l’IA a un impact majeur sur l’industrie du jeu et son influence ne fera que croître dans les années à venir. L’IA est utilisée pour créer des univers de jeu plus réalistes et plus immersifs, développer de nouveaux mécanismes de jeu et personnaliser l’expérience de jeu pour chaque joueur.

Ce n’est que le début de ce que l’IA peut faire pour l’industrie du jeu. Au fur et à mesure que la technologie se développe, nous pouvons nous attendre à voir des applications de l’IA encore plus innovantes et révolutionnaires dans les jeux.