Grâce à la norme universelle de description de scène, explique Richard Kerris de Nvidia, vous pourrez passer d’un monde 3D à l’autre aussi facilement que vous naviguez sur des sites Web.

Lorsqu’il a été présenté pour la première fois par Mark Zuckerberg de Meta l’automne dernier, certains milieux étaient sceptiques quant au métavers, le système d’avatars et de mondes virtuels que Mark Zuckerberg est en train de construire et qui, selon lui, sera la prochaine version d’Internet.

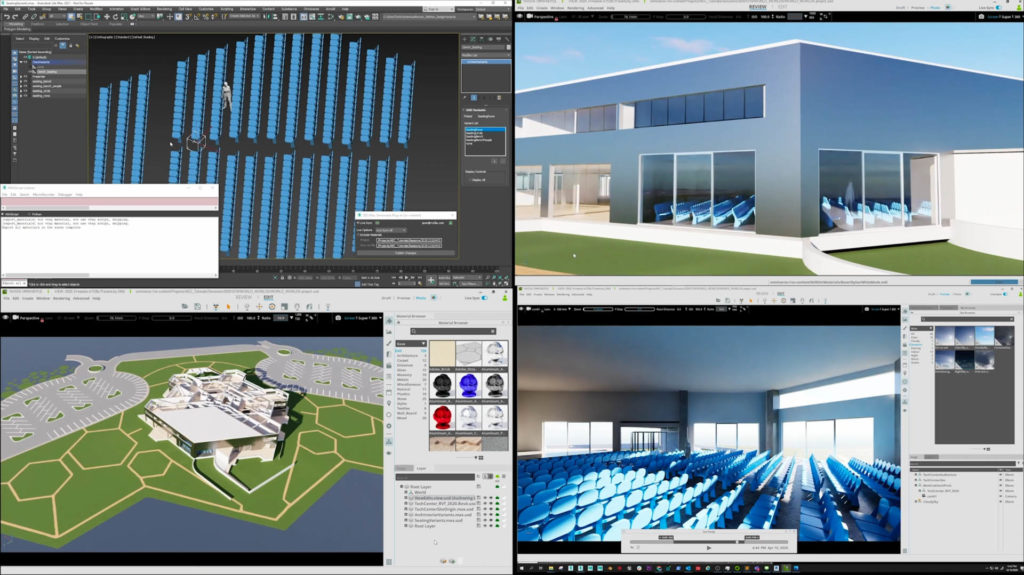

Richard Kerris, qui dirige chez le géant des puces Nvidia une équipe d’une centaine de personnes travaillant à l’élaboration d’une technologie pour le métavers, connu sous le nom d’Omniverse (plus d’informations ici), n’est pas du tout sceptique quant à ce monde futur.

Il est cependant sceptique sur une chose.

« La seule chose qui me laisse sceptique, c’est la façon dont les gens ont tendance à en parler », a déclaré Kerris à ZDNet, lors d’un récent passage à New York pour rencontrer des développeurs.

« Les gens interprètent mal le métavers comme une destination, un monde virtuel, un ceci ou un cela », a observé Kerris. « Le Metaverse n’est pas un lieu, c’est le réseau de la prochaine version du Web.

« Remplacez simplement le mot métavers par le mot réseau, et vous commencerez à comprendre. »

Le réseau, dans le sens où Kerris l’utilise, est une sorte de technologie sinueuse qui reliera les médias riches sur de nombreux sites Web, notamment le contenu 3D.

« De la même façon que le Web a unifié tant de choses […], la prochaine génération de ce Web, dont les principes fondamentaux seront la 3D, sera un défi à relever pour rendre cette technologie omniprésente dans les mondes virtuels.

« Le résultat final serait, de la même manière que vous pouvez aller de n’importe quel appareil à n’importe quel site Web sans avoir à charger quelque chose – rappelez-vous le bon vieux temps – Quel navigateur avez-vous ? Tout cela a disparu avec la ratification du HTML. Tout cela a disparu avec la ratification du HTML. Lorsque nous pourrons faire cela avec la 3D, ce sera une transformation. »

Sans surprise étant de Nvidia, qui vend la grande majorité des puces graphiques (GPU) pour rendre la 3D, Kerris a fait remarquer que « nous vivons dans un monde en 3D ; nous pensons en 3D », mais le Web est une réalité en 2D. « Il est limité », a-t-il dit, avec des îlots de capacités de rendu 3D qui ne s’interconnectent jamais.

« C’est la cohérence des mondes connectés qui est à l’origine de la magie qui s’opère, a-t-il ajouté. « Je peux me téléporter d’un monde à l’autre, et je n’ai pas besoin de le décrire à chaque fois que je le construis ».

L’analogue du HTML pour ce nouvel écosystème 3D est quelque chose appelé USD, description universelle de la scène. Comme l’a écrit Stephanie Condon de ZDNet, USD est un cadre d’échange inventé par Pixar en 2012, qui a été publié en tant que logiciel open-source en 2016, fournissant un langage commun pour définir, emballer, assembler et éditer des données 3D.

(Kerris, un vétéran d’Apple, a une sorte de lien spirituel, sinon réel, avec Pixar, ayant travaillé chez LucasFilm pendant plusieurs années au début des années quatre-vingt-dix. Pour en savoir plus, consultez son profil LinkedIn).

USD est capable de décrire de nombreuses choses dans un environnement 3D, de l’éclairage au comportement physique des objets qui tombent.

Dans la pratique, Kerris imagine le métavers défini par USD et activé par l’Omnivers comme un road trip où les gens sautent d’un monde 3D à l’autre aussi facilement qu’ils naviguent sur des sites traditionnels. « Je peux passer d’une usine virtuelle à un centre de villégiature virtuel, à une salle de conférence virtuelle, à un centre de conception virtuel ou à n’importe quoi d’autre », a déclaré M. Kerris.

Dans ces environnements, le rendu 3D permettra aux gens d’aller au-delà de l’encombrant sneakernet du partage de fichiers. « Et cela permet d’offrir beaucoup plus de possibilités dans ce que je fais », a-t-il ajouté, en donnant l’exemple des concepteurs de produits.

« Avec le métavers, et la plomberie omniprésente pour la 3D, nous serons dans cet environnement 3D en même temps, et plutôt que de partager une page Web, nous pourrons nous déplacer. Vous pouvez regarder quelque chose de ce côté du produit. Je peux regarder autre chose, mais c’est comme si nous étions dans la même pièce au même moment. »

Nvidia, a déclaré M. Kerris, a commencé à s’intéresser à l’USD il y a six ou sept ans « parce que nous simulons tout ce que nous construisons [chez Nvidia] avant de le construire dans le monde physique », a-t-il ajouté. Nvidia a des pairs dans l’industrie qui travaillent sur la réalisation de la technologie, notamment Ericsson, qui veut simuler des antennes. « Ils veulent tous une simulation de la réalité », a-t-il dit à propos des entreprises dans le giron de Nvidia.

Selon M. Kerris, cette technologie permet d’aller beaucoup plus loin dans le domaine des jumeaux numériques, des simulations de produits et de structures qui permettent d’intervenir, d’expérimenter et d’observer.

« Jusqu’à l’avènement de la plomberie cohérente, cela se faisait en mode représentatif », a-t-il dit, comme l’illustration d’un bâtiment dans Autodesk. « Ce n’était pas fidèle à la réalité. Je ne pouvais pas vous montrer exactement comment cela se passerait en cas de tempête de vent », ce qui n’est pas bon car, comme il l’a dit, « je veux être sacrément direct sur les choses que je construis dans le monde physique. »

La « base centrale d’une situation qui est fidèle à la réalité », en utilisant l’USD, permettra aux concepteurs de simuler plus précisément, à rebours et en avant, y compris des choses comme la résistance à la traction.

« J’aimerais avoir une maison dont la structure est solide avant de concevoir la finition en marbre », a-t-il observé. « Si je construis un jumeau numérique d’une maison que je suis en train de construire, il y a des couches de choses dessus, des choses pour les ingénieurs structurels, et du polissage que d’autres vont venir terminer. » L’important est de savoir que les matériaux et les éléments qui tiennent la structure ensemble sont « fidèles à la réalité », a-t-il ajouté.

En rendant possibles ces interactions plus riches en 3D, Kerris a déclaré : « De la même manière que le Web a transformé les entreprises, les expériences et la communication, le métavers fera de même, et dans un environnement plus familier, car nous travaillons tous en 3D ».

Les différentes entreprises contribuent à l’USD de différentes manières. Par exemple, Nvidia a travaillé avec Apple pour définir ce que l’on appelle la dynamique des corps rigides.

« Et ce n’est pas tout », a-t-il ajouté.

Nvidia a développé les outils Omniverse en tant que « plateforme », ce que Kerris appelle « le système d’exploitation du métavers ».

« Les gens peuvent s’y connecter. Ils peuvent construire par-dessus. Ils peuvent s’y connecter. Ils peuvent le personnaliser – il est vraiment à leur disposition, un peu comme l’est un système d’exploitation aujourd’hui. »

Selon M. Kerris, la norme USD est « assez avancée » en termes d’adoption, la plupart des sociétés de 3D l’utilisant. « Chaque entreprise du secteur du divertissement a une stratégie USD aujourd’hui », a-t-il observé. « La CAO [conception assistée par ordinateur] et l’ingénierie mécanique, c’est pour bientôt. Soit ils ont des plans, soit ils participent à l’aide à la définition de ce qui est nécessaire. »

« Le HTML était de la même façon à ses débuts, a-t-il ajouté. Il ne prenait pas en charge la vidéo à ses débuts, et des plugins tiers comme Adobe Flash ont dominé avant que les normes n’évoluent.

Les jumeaux numériques vont-ils enflammer l’imagination du monde sur le métavers ? Cela semble un peu trop axé sur l’industrie, a observé ZDNet.

Les gens ordinaires gagneront en intérêt lorsqu’ils réaliseront qu’il s’agit de connectivité, et non d’une destination unique. « Lorsqu’ils réaliseront qu’il s’agit de la prochaine génération du Web, je pourrai me rendre dans un endroit éloigné sans avoir besoin d’un casque ou d’installer des navigateurs spécifiques. C’est un aspect », a déclaré M. Kerris. « Dans leur vie quotidienne, comme nous partageons des photos aujourd’hui, vous serez en mesure de partager des objets. Vous savez, votre enfant rentre à la maison, et il a fabriqué quelque chose et il pourra le partager avec les grands-parents. »

« Ça va juste devenir une partie de ce que vous faites, que vous achetiez un meuble pour votre maison et vous allez aller dans votre téléphone. Vous vous synchroniserez avec la maison. Vous déposez le meuble à l’intérieur. Vous vous promènerez autour – c’est ce que les gens considéreront comme acquis, mais c’est la connexion transparente. »

Il en va de même pour la conception de la finition de sa voiture personnalisée, a-t-il proposé. « Vous serez réellement connecté à l’usine qui fabrique cette voiture » pour en vérifier tous les aspects.

« Cela va tout changer », a-t-il déclaré.

Il y aura des effets multiplicateurs, a ajouté M. Kerris, car les jumeaux numériques permettent de tester plusieurs scénarios, comme dans le cas des robots de formation.

« Aujourd’hui, on branche un ordinateur sur le robot et on lui fournit des informations » pour le former dans un seul espace physique, a-t-il expliqué. Dans un environnement de jumeau numérique, avec un robot dans la pièce simulée, « vous pouvez former non seulement un robot mais des centaines », en utilisant « des centaines de scénarios que le robot pourrait rencontrer ».

« Maintenant, ce robot va être des milliers de fois plus intelligent qu’il ne l’aurait été si vous l’aviez entraîné une seule fois ». Nvidia a, en fait, poursuivi cette approche particulière pendant de nombreuses années en faisant de la formation à la conduite autonome de l’apprentissage automatique dans des environnements routiers simulés.

Bien que la conduite autonome n’ait pas atteint le développement promis, Kerris estime que l’approche est toujours valable. « Je peux construire un jumeau numérique de Palo Alto », la ville de la Silicon Valley. « Et je peux avoir des milliers de voitures dans cette simulation, qui roulent, et je peux utiliser l’IA pour appliquer tous les types de simulation auxquels je peux penser – une tempête de vent, un enfant qui sort en courant, qui court après un ballon, une marée noire, un chien – de sorte que ces voitures en simulation apprennent plusieurs milliers de fois plus de scénarios que ne le ferait une voiture physique. »

Nvidia a fait du travail, combinant les essais simulés avec la conduite réelle avec le constructeur automobile Mercedes pour la conduite autonome de niveau 5, le niveau le plus exigeant.

« L’efficacité est assez étonnante », a-t-il dit, c’est-à-dire la façon dont le logiciel autonome gère les scénarios routiers. « En utilisant des données synthétiques pour former ces voitures, vous avez un plus haut degré d’efficacité » lors de la combinaison des scénarios.

« Je préfère de loin me faire confiance en roulant dans une voiture entraînée dans un environnement simulé plutôt que [dans] une voiture entraînée dans un environnement physique. » Il y aura toujours un rôle pour les données du monde réel qui proviennent des voitures sur la route.

Quant à l’échéance de cette vision, Kerris a noté que « nous la voyons déjà dans les entrepôts », qui adoptent rapidement le régime de formation des robots. Cela inclut Amazon, où un développeur a téléchargé Omniverse et l’a évangélisé au sein d’Amazon. La version entreprise d’Omniverse, qui est un produit sur abonnement, a été adoptée par Amazon pour une formation plus poussée des robots.

Amazon utilise actuellement le logiciel pour ses robots de prélèvement et de placement.

« La beauté de la chose, c’est qu’ils ont découvert qu’en utilisant la génération de données synthétiques, ils étaient capables d’être plus efficaces au lieu de se fier uniquement à la caméra » du robot pour la détection des objets. Ces caméras étaient souvent gênées par le ruban d’emballage réfléchissant sur les paquets, a expliqué M. Kerris. L’utilisation de données synthétiques générées par Omniverse a permis de contourner cette limitation. C’est un exemple d’efficacité accrue en robotique, a-t-il ajouté.

Les consommateurs ressentiront probablement les effets de ces simulations dans les résultats.

« Il y a cent mille entrepôts sur la planète », a déclaré Kerris. « Ils cherchent tous à utiliser la robotique pour être plus sûrs, plus efficaces et pour mieux utiliser l’espace ». Les gens « ne sont peut-être pas conscients de ce qui se passe, mais ils en récolteront les fruits. »

Dans certaines situations, les consommateurs « le sauront, car ils obtiennent les choses beaucoup plus rapidement que par le passé », a-t-il ajouté. « Derrière le rideau, les choses seront beaucoup plus efficaces qu’il y a six mois ». Il en va de même pour les détaillants tels que Kroger, qui utilise les outils d’Omniverse pour générer des données synthétiques afin de planifier la manière d’acheminer plus rapidement les produits aux consommateurs.

Quant aux voitures autonomes, « la présomption que toutes ces voitures seront autonomes aujourd’hui, c’est un peu – ce n’est pas encore le cas », a-t-il concédé. « Mais aurons-nous des taxis autonomes, et des choses qui nous emmèneront d’ici à là ? Oh, oui, c’est facile. »

Mais, « pour une voiture qui s’approche de vous et qui vous conduira au New Jersey de manière autonome ? Nous avons encore un peu de chemin à parcourir. »

En ce qui concerne les expériences directes des consommateurs, « les gens vont commencer à voir la possibilité d’expérimenter des lieux », a déclaré M. Kerris. Les dirigeants de l’industrie des loisirs s’intéressent, par exemple, à la manière de montrer une chambre d’hôtel aux consommateurs avant un voyage, d’une manière plus efficace que les photos. « Je vais vous permettre de vous téléporter dans la chambre, d’en faire l’expérience, de sorte que votre décision sera fondée sur une expérience immersive. Regardez la fenêtre, voyez quelle sera ma vue », a déclaré M. Kerris.

L’impact sur l’éducation « va être énorme », a ajouté M. Kerris. Aujourd’hui, en raison de leur situation géographique, certaines écoles des quartiers défavorisés ne peuvent pas organiser de somptueuses sorties éducatives. « Une école d’un quartier défavorisé n’aura pas vraiment l’occasion d’aller faire un safari en Afrique », a-t-il dit. « Je pense que les mondes virtuels [qui] sont connectés de manière transparente peuvent apporter de nouvelles opportunités en permettant à tout le monde de vivre la même expérience, quelle que soit l’école dans laquelle il se trouve. »

Un avatar de chercheur tel que Jane Goodall pourrait « inspirer l’apprentissage », a-t-il suggéré. « Pensez à ce que cela fait pour un étudiant ».

Tout en mettant l’accent sur la 3D, Kerris ne pousse pas la réalité virtuelle ou la réalité augmentée, les deux technologies sur lesquelles les gens ont tendance à se concentrer. Ces technologies font partie du tableau, mais la 3D ne doit pas nécessairement se faire avec un casque, a-t-il affirmé.

D’une part, les outils de RV actuels, comme les vidéos de RV sur YouTube qui utilisent des casques de RV conventionnels, sont assez limités, a déclaré Kerris. « Ce n’est pas transparent, ce n’est pas facile, ce n’est pas comme un site web », a-t-il observé.

En plus de ses passages chez Apple, Amazon et LucasFilm, Kerris a brièvement dirigé le marketing du développeur de casques Avegant. Ces casques n’étaient pas VR. Ils étaient conçus pour être des écrans de cinéma privés et immersifs fixés sur votre visage à l’aide de puces de projection DLP de Texas Instruments. La qualité du produit, se souvient Kerris, « était phénoménale », mais il était trop cher à fabriquer, coûtant 800 dollars au détail. Et le fait qu’un laser puisse projeter sur la rétine « effrayait tout le monde », a-t-il ajouté. (Avegante est toujours en activité, développant une technologie appelée cristaux liquides sur silicium).

Ce qu’il faut, c’est que les environnements virtuels disparates d’aujourd’hui reçoivent ce tissu tendu d’USD et de technologies connexes. « Ils sont tous déconnectés », a déclaré Kerris à propos des proto-métavers d’aujourd’hui, comme l’Oculus Rift. « S’il ne s’agissait que de simples sites web, où vous pourriez vous balader et aller faire l’expérience, l’opportunité serait bien plus grande. »

Plutôt que d’avoir un casque Oculus, « si je pouvais en faire l’expérience avec ceci comme fenêtre sur ce monde », a-t-il dit en brandissant son smartphone, « il y a beaucoup plus de chances que j’aille y jeter un œil. »

Est-ce que USD fera en sorte que cela se produise ?

« Oui. C’est absolument l’objectif d’USD, qui est d’unifier les mondes virtuels 3D. »

Pourtant, la mise en place d’un showrooming des chambres d’hôtel n’est pas de nature à faire avancer les choses. À quand l’événement Tim Berners-Lee qui permettra aux consommateurs de s’approprier le projet ?

« Quand le Web est-il devenu quelque chose d’omniprésent chez les consommateurs ? » a-t-il demandé, de manière rhétorique. « Eh bien, ça a commencé avec le courrier électronique, puis je pouvais envoyer une photo, puis, tout d’un coup, je pouvais faire de la vidéo. Ça a évolué au fur et à mesure ».

Kerris a fait allusion aux premiers jours des sites web mobiles sur iPhone, lorsque Steve Jobs a dévoilé pour la première fois la technologie en janvier 2007 sur la scène de Macworld, alors que Kerris était chez Apple, et plus tard, lors d’un chat vidéo via FaceTime,

« Quelle a été la chose transformatrice qui a permis au Web d’être dans la poche de tout le monde ? C’est un peu comme ça », a-t-il dit. « C’est presque arrivé alors que vous ne le saviez pas, et ensuite les gens le prennent pour acquis ».

Adapté de ZDnet