n objectif d’intégration mis en avant l’intelligence artificielle Sous forme de lunettes tastyemhasizing son rôle d’assistant Pour aider l’utilisateur dans sa vie quotidienne, tout en continuant à faire des recherches sur cette technologie émergente et sur les métavers.

Amnesty International et metaverse elle Gros paris Objectif à long terme, deux technologies émergentes Qui cette année ont commencé à se croiser ‘façonné des produits Abordables Pour un grand nombre de personnes « , comme indiqué sur son site officiel.

Plus précisément, le niveau de maturité atteint par l’entreprise dans ces deux technologies lui a permis d’avoir une « vision plus claire » de l’innovation qu’elle estime devoir apporter aux utilisateurs au cours de la prochaine décennie.

D’une part, l’IA de recherche doit encore faire des progrès fondamentaux et découvrir des architectures entièrement nouvelles.

D’autre part, des équipes méta spécialisées travaillent dans des domaines tels que l’IA incarnée, qui vise à construire des modèles qui expérimentent le monde de la même manière que les humains.

En ce qui concerne le métavers, les chercheurs des laboratoires de réalité travaillent sur les technologies qui rendront possible la prochaine plateforme informatique.

Jusqu’à présent, leurs travaux ont permis de développer les lentilles « pie » Quest Pro et Quest 3, ainsi que le prototype Avatars Codec, pour créer une représentation 3D réaliste de l’utilisateur avec un son spatial.

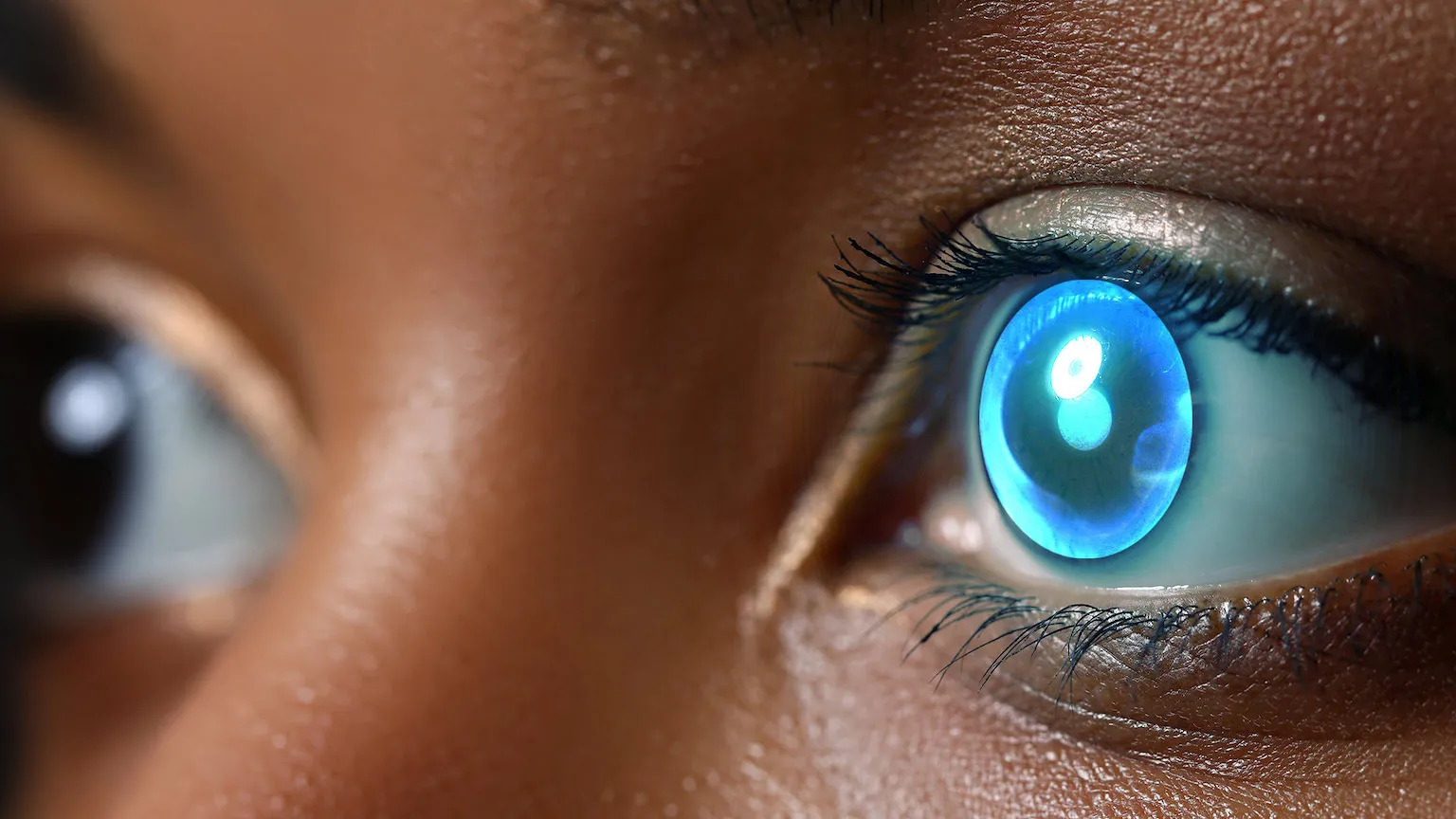

L’actualité met en lumière l’intégration de l’intelligence artificielle dans les lunettes intelligentes qui, selon Meta, deviendront « la principale façon dont les gens interagissent avec les machines ».

Les lunettes qu’ils développent avec Ray-Ban en sont un exemple : la nouvelle génération intègre un assistant Meta AI qui associe la compréhension du langage à la vision par ordinateur pour voir le monde du point de vue de l’utilisateur.

En ce sens, l’entreprise teste déjà de nouvelles capacités d’intelligence artificielle multimédia qui permettront de traduire un texte en langue que l’utilisateur lit ou de créer un titre intéressant pour une photo qu’il a prise. Cela se fait « les mains libres, sans avoir à décrocher le téléphone ou à lancer l’application », garantit-on à Meta.